Contrôlez vos processus, libérez vos équipes de données

Permettre l'autonomie (self-service)

Permettre à tout utilisateur de données de construire des pipelines de données en quelques clicsGérer l'accès et maintenir la visibilité de toute activité

Automatiser les déploiements

Déployer instantanément entre environnements et versionsIntégrer et s'adapter à votre approche CI/CD (Continuous Integration/Continuous Deployment)

Monitorer avec facilité

Surveillez de manière proactive la santé de vos pipelines de donnéesObtenir une visibilité complète sur vos processus ELT (Extract, Load, Transform) et les coûts associés

Intégration automatisée des données

Tout ce dont vous avez besoin pour rationaliser vos opérations de données

Gestion collaborative des données

- Utiliser des environnements cloisonnés pour permettre aux différentes équipes de votre organisation de gagner en autonomie, tout en bénéficiant d’un accès régulé.

- Gérer et contrôler la visibilité de l’accès aux données, y compris la gestion des rôles et des permissions de manière granulaire

- Créer des modèles de données de référence qui peuvent être répliqués ou utiliser un modèle pré-construit existant

Déployez des modèles de données en toute confiance

- Déployez vos pipelines en un click vers les environnements Dev, QA et Production avec des variables d’environnements

- Exploitez le contrôle de version pour revenir en arrière et restaurer la configuration et le code selon vos besoins

- Utilisez le CLI et l’API de Rivery pour déployer en utilisant votre méthode CI/CD préférée

Fiez-vous à vos processus de données

- Créez des alertes qui aident de manière proactive les parties prenantes à gérer tout problème dans l’écosystème DataOps

- Monitorer l’activité et la consommation, depuis une vue agrégée jusqu’aux tâches spécifiques

- Utilisez l’API de Rivery pour intégrer votre solution de catalogue et de lignage préférée

Koby Berkovich,

CTO et VP R&D, chez Alison.

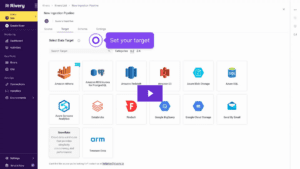

Comment déployer de nouveaux pipelines

1

Créez un package de déploiement pour vos environnements source et cible.

2

Sélectionnez les objets (par exemple, pipelines, connexions, variables) à déployer.

3

Contrôlez vos paramètres avancés de déploiement et exécutez votre déploiement.

Découvrez-le en action – Environnements et Déploiements

FAQs

DataOps est une pratique de gestion des données collaborative qui met l’accent sur la communication, l’intégration et l’automatisation du flux de données entre les gestionnaires de données et les consommateurs au sein d’une organisation. Elle vise à améliorer la qualité et à réduire le cycle temporel de l’analytique des données en adoptant des techniques issues de la méthodologie DevOps.

Les objectifs principaux de DataOps incluent l’amélioration de la collaboration entre les équipes de données, l’amélioration de la qualité et de la fiabilité de l’analytique des données, l’accélération du développement et du déploiement de projets liés aux données, et l’assurance que les opérations de données sont alignées avec les objectifs commerciaux.

DataOps se distingue des pratiques traditionnelles de gestion des données en mettant l’accent sur la collaboration, l’automatisation et l’agilité. Elle promeut une culture de collaboration entre les ingénieurs de données, les data scientists et les analystes commerciaux, et elle utilise des outils d’automatisation pour rationaliser le pipeline de données, garantissant ainsi une livraison plus rapide et plus fiable des insights basés sur les données.

L’automatisation est un principe fondamental de DataOps. Elle automatise des tâches répétitives telles que l’intégration, le test, le déploiement et la surveillance des données. En automatisant ces processus, les équipes DataOps peuvent augmenter l’efficacité, réduire les erreurs et accélérer la livraison de solutions d’analytique de données de haute qualité.

DataOps améliore la qualité des données en automatisant la validation, le nettoyage et l’enrichissement des données. Elle assure que les pipelines de données sont surveillés en temps réel, permettant la détection et la correction immédiates des erreurs. En maintenant des standards de haute qualité tout au long du cycle de vie des données, DataOps renforce la fiabilité des résultats analytiques.

Oui, DataOps peut être appliquée aussi bien aux données structurées que non structurées. Que les données soient dans des bases de données, des feuilles de calcul, des fichiers texte ou des formats multimédias, les principes et les pratiques de DataOps peuvent être adaptés pour gérer, traiter et analyser divers types de données.

DataOps renforce l’agilité commerciale en permettant des cycles de développement plus rapides et des sorties plus fréquentes de projets liés aux données. En automatisant les processus et en favorisant la collaboration, DataOps assure que les entreprises peuvent répondre rapidement aux demandes changeantes du marché et prendre des décisions basées sur des données à jour et fiables.

Les défis courants lors de la mise en œuvre de DataOps incluent la résistance culturelle au changement, l’intégration des pratiques DataOps dans les flux de travail existants, l’assurance de la sécurité des données et de la conformité, la sélection d’outils et de technologies appropriés, et la gestion de la complexité des sources de données diverses. Surmonter ces défis nécessite une approche stratégique et un engagement de tous les intervenants.

Automatisez les pipelines de données ELT